È incredibile come una piccola scelta manageriale può cambiare totalmente il posizionamento di una big tech per sempre. Trovo anche assurdo che un'istituzione come Apple, che ha a disposizione le più grandi e infallibili agenzie di advisory, possa aver deciso di non investire tempestivamente in AI. Voglio dire... lo sapevano che stava arrivando la rivoluzione più grande mai vista, proprio come già conoscono i trend che diventeranno normalità tra cinque o dieci anni.

Infatti, come abbiamo delineato in passato, non è stata una scelta manageriale ma una realtà a livello di risorse umane: dipartimenti troppo lontani fra loro non hanno mai imparato a comunicare e quando è arrivato qualcosa di così orizzontale come l'IA sono esplosi, non ce l'hanno fatta. Ne abbiamo parlato in questo editoriale:

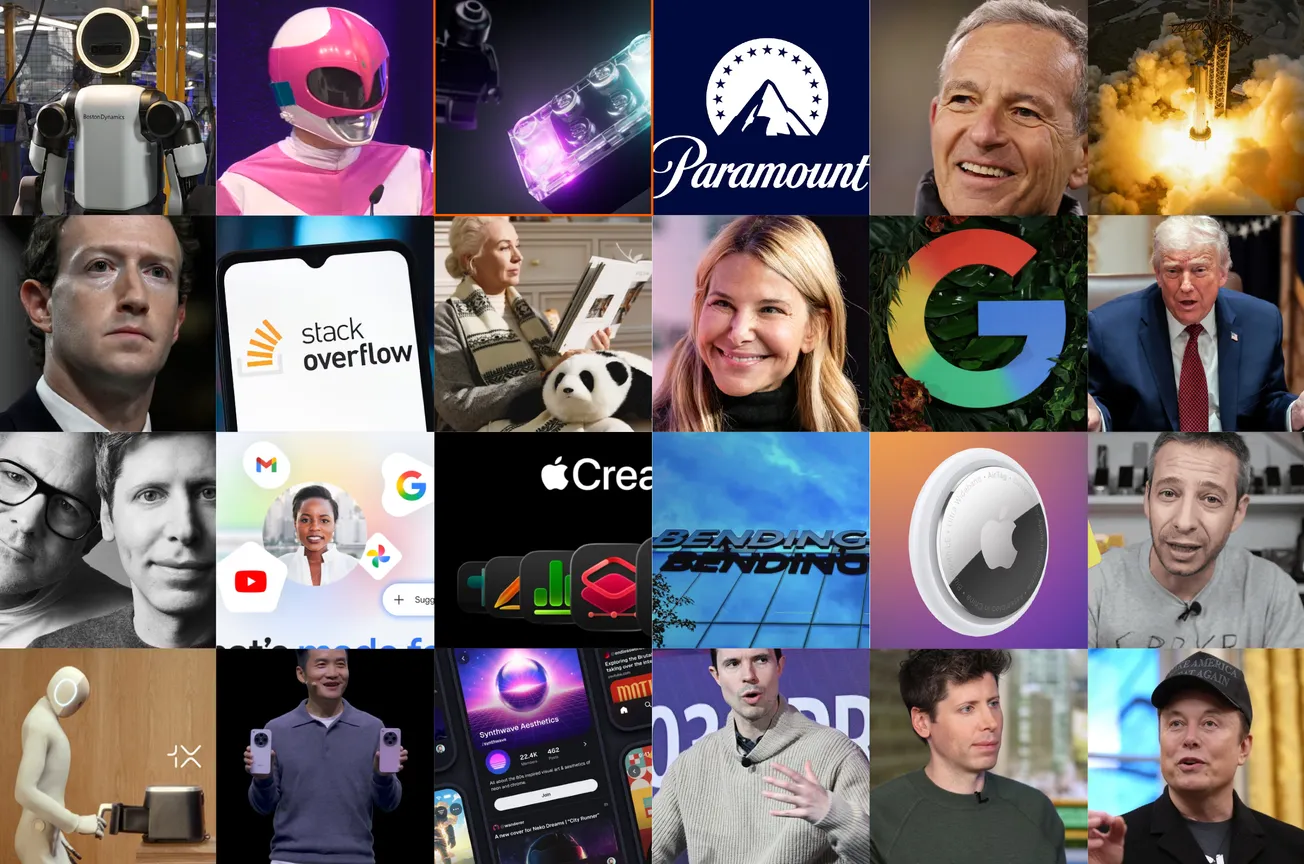

Ne ha parlato Mark Gurman di Bloomberg, e qualcuno si è anche nostalgicamente detto "Se c'era Jobs non sarebbe mai successo".

Beh Jobs non c'è e il treno del chatbot proprietario è passato, perché di LLM in realtà Apple ne ha sviluppati, tutti quelli che ad esempio vivono oggi in Apple Intelligence e che modificano le foto o lavorano sui testi, ma il modello dei modelli? Un chatbot conversazionale che ti parla, ti capisce, ti conosce e diventa piano piano un agente? Non ce n'è e — secondo me — non ce ne sarà traccia.

Anarchia dei dati

I crawler esistono da qualche decennio, quegli script che setacciano il web per ottenere informazioni. Tradizionalmente venivano utilizzati dai motori di ricerca per indicizzare i siti web e ricordo che una quindicina di anni fa quando ci si lamentava di un nuovo sito appena messo online che ancora non era indicizzato era perché aspettavamo che passasse il GoogleBot — che in gergo chiamavamo "spider". Ricordo anche gli anni in cui lo spider progredì ed iniziò a passare più frequentemente.

Ai tempi nessuno si lamentava del crawler di Google anzi, tutti lo attendevano a gloria.

Tra la fine del 2017 e l'inizio del 2018 sono apparsi i primi crawler con un obiettivo diverso, che la comunità, anche quella tech, ancora non capiva: addestrare un'IA. È stato cinque anni dopo, con l'avvento di GPT-3.5 che le persone hanno iniziato davvero a capire, ma il training stava già prendendo piede, anche per LLM che ancora non avevano visto la luce ma che sarebbero usciti nel 2023.

Dal 2023 al 2025 c'è stato uno spike assurdo nelle risorse impiegate per l'addestramento. Secondo l'ultimo studio di Stanford, sul quale abbiamo scritto un editoriale qui:

solo il modello Gemini 1.0 Ultra di Google ha richiesto circa 192 milioni di dollari di investimento per addestrarsi.

Quelli sono stati gli anni in cui internet è stata spremuta al massimo, anni in cui non ci sono state regole e i crawler hanno divorato famelicamente qualsiasi cosa. È stato solo di recente che sono partite tutte le denunce e oggi non c'è un'azienda dietro a un LLM degno di nota che non abbia visto un tribunale.

Fine della pacchia

Un altro tema centrale è il robots.txt, un file che i siti web utilizzavano per dire a Google e ai vari crawler "hey, non indicizzate questa pagina web." Proprio come un bigliettino che lasci sulla bici, nell'androne delle scale, per dire ai condomini "non toccatela, la sposto domani," ma con un potere di effettiva protezione praticamente nullo.

Questo potere, di fatto, non l'avevano ancora inventato. Lo dimostra Wikipedia che di recente ha voluto sviluppare uno script custom per bloccare i crawler che stavano sovraccaricando i suoi server o Cloudflare che si è immolata per proteggere i proprietari di siti web rilasciando i primi servizi ad-hoc.

Oggi, agosto 2025, i siti web, soprattutto quelli che generano contenuti originali si stanno proteggendo: NewsGuard ha rilevato che il 67% di 414 grandi siti di news autorevoli bloccano i principali crawler AI. Meta, grazie all'attenzione delle normative europee, l'anno scorso ha dovuto implementare un opt-out per permettere agli utenti di Facebook, Instagram e Threads di non dare in pasto i propri contenuti pubblici a Llama.

Perché Apple non può avere un chatbot proprietario?

Sia chiaro, certo che può averlo, ma con uno svantaggio enorme rispetto agli altri. Un addestramento fatto oggi è completamente diverso da uno fatto due anni fa. Come detto, i siti web di contenuti originali si stanno proteggendo e non vogliono che tu ingurgiti i loro testi, video e immagini, senza nemmeno portargli traffico e addirittura influenzando negativamente il loro business model.

Inoltre, la versione 1 di GPT era tremenda, ma erano (per gli standard attuali) piuttosto "zoppi" anche i primi Gemini, Grok, Llama, ecc. La differenza è che sono stati pubblicati in tempi in cui andava bene anche se allucinavano o funzionavano male. Anzi, faceva parte di quel periodo storico e quasi ci piaceva prenderli in giro.

Un periodo che è passato: immagina una prima release di un chatbot conversazionale di Apple, che non è mai stato ottimizzato sulla base dell'utilizzo degli utenti, che deve essere già in grado di conversare con fluidità ed espressività umana — dal momento che tutti se lo aspettano su Siri — sarebbe un flop totale, in un momento di sentiment completamente negativo nei confronti degli effort di Apple con l'IA. Ricordiamo che l'intera lineup degli iPhone 16 è stata venduta con grosse promesse lato IA (anche su Siri), molto poco mantenute, che hanno portato addirittura ad una class action.

Il futuro del training

I crawler vengono sempre di più bloccati, vuol dire che non potremmo più addestrare l'IA? Penso che sia un argomento delicato: la visione nascente è quella di prediligere la qualità alla quantità, facendo una selezione dei contenuti che in molti casi andranno pagati. Big tech come Cloudflare (ma anche altre piccole startup) stanno lavorando per dare anche ai piccoli creatori il modo di guadagnare denaro quando il loro contenuto viene ingerito da un LLM.

Il futuro è fatto di licenze e partnership, proprio come gli accordi siglati da OpenAI con AP, Financial Times, TIME, The Atlantic, Vox, e altri. Qualcuno continuerà a barare e attenderà di essere denunciato, qualcun'altro punterà tutto sui dati artificiali, cioè dati creati ad-hoc dalla stessa IA per auto-addestrarsi. Il futuro del training è molto incerto.