Questo testo è un riassunto del seguente articolo: Ars Technica (eng)

Presentazione ufficiale: Google (eng)

Riassunto

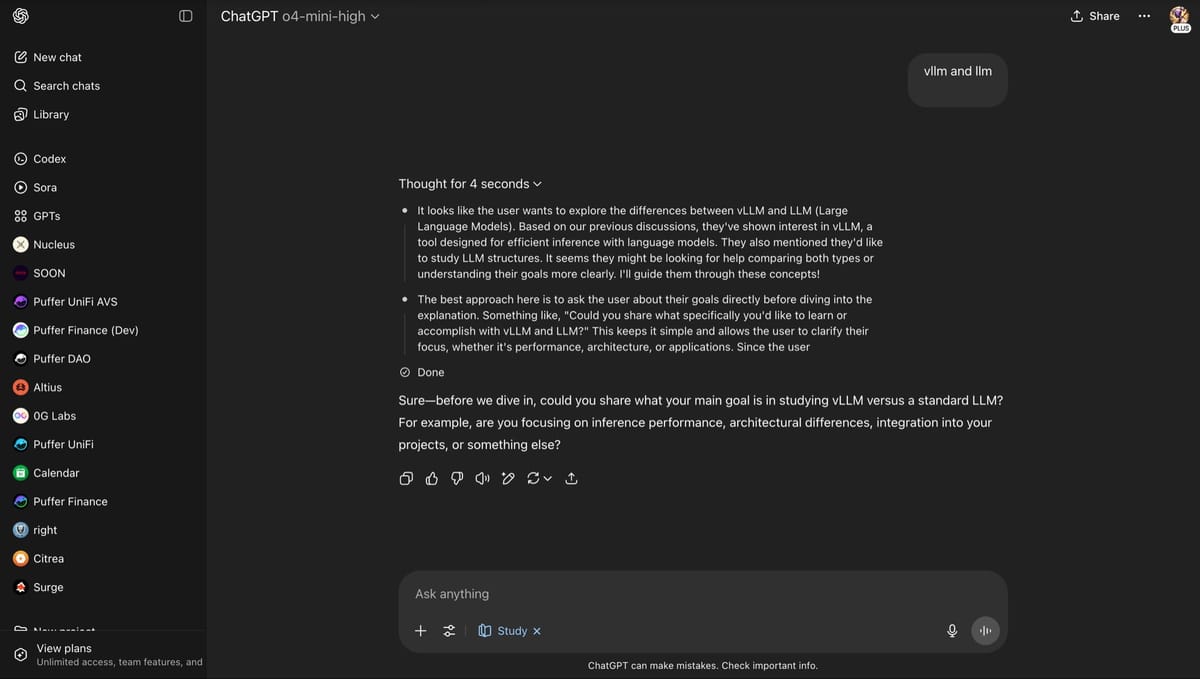

Mercoledì Google ha lanciato Gemini 2.0, una nuova generazione di modelli di intelligenza artificiale che include una versione sperimentale chiamata Gemini 2.0 Flash. Questi modelli sono capaci di generare testo, immagini e parlato, mentre elaborano input di vario tipo come testo, immagini, audio e video, seguendo un approccio multimodale.

Simile ad altri modelli come GPT-4 di OpenAI, Gemini 2.0 Flash è presentato come un miglioramento rispetto al suo predecessore, il modello 1.5 Flash, con prestazioni superiori e tempi di risposta rapidi.

Disponibile attraverso le piattaforme per sviluppatori di Google come Gemini API, AI Studio e Vertex AI, le sue funzionalità di generazione di immagini e conversione testo-voce restano limitate ai soli partner con accesso anticipato fino a gennaio 2025. Google prevede di integrare questa tecnologia in strumenti come Android Studio e Chrome DevTools.

Per prevenire abusi, tutti i contenuti generati utilizzano la tecnologia SynthID, che funge da filigrana per l'identificazione.

Perché è importante?

Perché Google con questa release inizia a spostare l'IA da un ruolo reattivo, cioè limitato alle risposte ai prompt, a un ruolo indipendente, cioè in grado di svolgere mansioni in autonomia, proprio come un agente. Tuttavia ad oggi questo presenta il grande rischio di operazioni non desiderate e richiede quindi ancora una supervisione umana.

L'attendibilità della fonte è stata analizzata tramite Media Bias/Fact Check.